“DX(数字化转型)”和“GX(绿色转型)”可以说是现代社会努力的两大趋势。在推动这些趋势方面,支持数字社会的基础设施——数据中心发挥着非常重要的作用(图1)。

在DX的实践中,为了汇聚生活和商业等当中使用的多样化海量数据,利用AI(人工智能)等提取帮助解决问题的知识,需要全社会共享和共用很大的存储能力和演算能力。此外,作为GX的一环,为了发现和消除隐藏在日常生活、生产活动、物流、运输、交通和社会活动中的能源浪费,需要对人员、货物、装置和设备等的流动进行细致的管理和控制。负责对这些DX和GX的实践所不可或缺的信息进行处理的就是数据中心。

数据中心对DX和GX实践不可或缺,但同时也带来了一个需要事先解决的两难问题。随着数据中心不断提高容量和增加据点,其耗电量激增,结果有可能危及数据中心本身是否能持续。本文对进一步提高数据中心能力的大前提——降低数据中心耗电量的技术以及有效的散热技术的开发动向进行相关解说。

数据中心的耗电量增加已成为一个社会问题

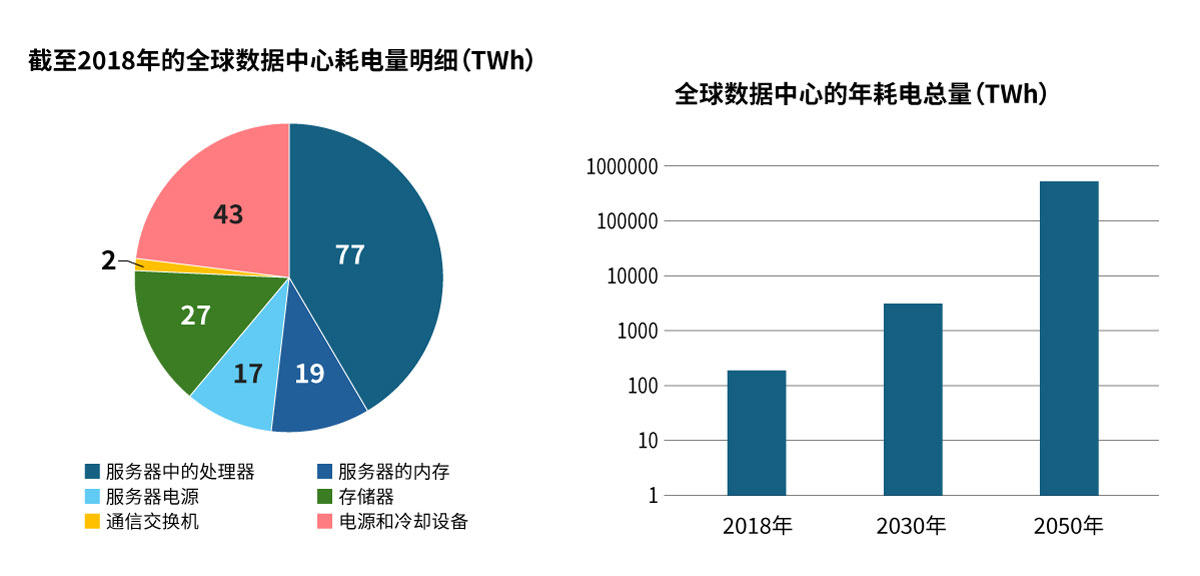

数据中心耗电量的增加已经成为一个明显的社会问题。根据一家全球性统计数据公司发布的调查结果,截至2024年3月,全球估计有9000多个数据中心。预计设置数量今后还将继续稳步增长。随着数据中心本身的增加,每年的总耗电量几乎每四年翻一倍。在数据中心设置得很多的美国,数据中心的规模在不断扩大,有些数据中心的规模达到了500MW。这相当于一个百万人口城市的电力需求。这意味着,现在已经到了需要将数据中心的设置与发电厂的设置结合起来考虑的时代了。

此外,生成式AI的学习处理等需要很强的演算性能的任务处理不断增加,这也加剧了耗电量增加的倾向。据说,生成式AI学习的耗电量是云服务处理的企业业务作业负荷的10到20倍。此外,执行AI处理的服务器通常配备前沿的GPU(Graphics Processing Unit),其中一些芯片的单个芯片年耗电量已达到了3.7MWh。这相当于一个普通家庭1年半的耗电量。

前沿电气和电子电路GPU等消耗的大量电能会在消耗的同时转化为热量。这些热量会对电气和电子电路本身的稳定运行造成影响。如果对发热导致的高温放置不管,可能会导致半导体无法正常工作。因此,数据中心安装了很强的空调设备来冷却服务器。目前,冷却空调系统本身的耗电量已达到数据中心总耗电量的30~50%(图2)。在当今的数据中心,为了应对信息处理需求的增加,服务器的高密度配置正在急速推进,伴随而来的是冷却效果也出现了下降的倾向。在此背景下,人们越来越渴望通过引入新技术来提高冷却系统的效率。

从液体冷却到基于AI的温度管理,冷却系统越来越新颖

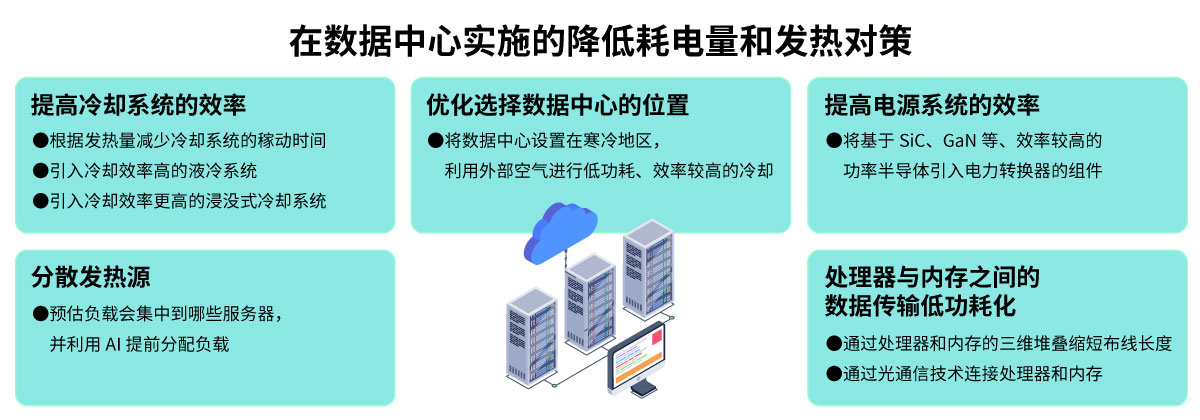

人们预计耗电量和发热量会增加,新设置的数据中心已经开始采用多种方法引入对策来降低耗电量和提高散热效率。以下对代表性举措进行介绍(图3)。

首先,目前人们正在推进改进效率,重点是冷却系统,因为冷却系统在数据中心的耗电量中占很大比例。在服务器中,作业负荷可能会因使用情况而大幅波动。因此,冷却系统需要引入根据发热量控制稼动时间的机制。通过控制冷却系统,使其只在需要时进行冷却,而不是持续进行冷却,由此可以降低耗电量。进行这种控制时,需要有效利用温度传感器等进行准确的动态温度管理。

除了传统的风冷系统外,近年来将其与液冷系统组合使用的例子也越来越多,液冷系统的冷却效率比风冷系统高约30%。在这种复合型冷却系统中,并非全部采用液体冷却,而是通过传感器检测发热量特别大的部分(热点),并相应调节该处的风冷系统风量。由此可以在保持服务器稳定运行的同时,尽可能地降低耗电量。

人们还在推进尝试一种稍微不同的方法,这种方法从冷却效率的角度在数据中心内设置的众多服务器之间分散负载。利用AI预估处理负载可能集中于哪些服务器,哪些服务器可能局部高温,并提前分散负载,使其只需尽可能少的冷却即可应对。通过这样将AI与空气冷却系统进行组合,在温度过度升高之前对送风量进行调整,尽可能地让冷却系统能够以短时间运行即能应对。

而且,近年来,考虑到演算能力的进一步提高会导致产生更多热量,人们开始尝试采用浸没式冷却系统,即将服务器本身浸入氟基惰性液体或硅油等当中,此类液体既有绝缘性,又能获得很好的冷却效率。作为更进一步的发展,还出现了将数据中心本身设置在寒冷地区,利用外部空气实现低功耗、效率较高的冷却事例。在研发层面,人们还在推进通过将数据中心的设备密封后设置在海中来进行冷却的技术开发。

引进新半导体,提高服务器电源系统的电力转换效率

人们还在开发和引入努力提高为服务器运行提供所需电力的电源系统效率的新技术。

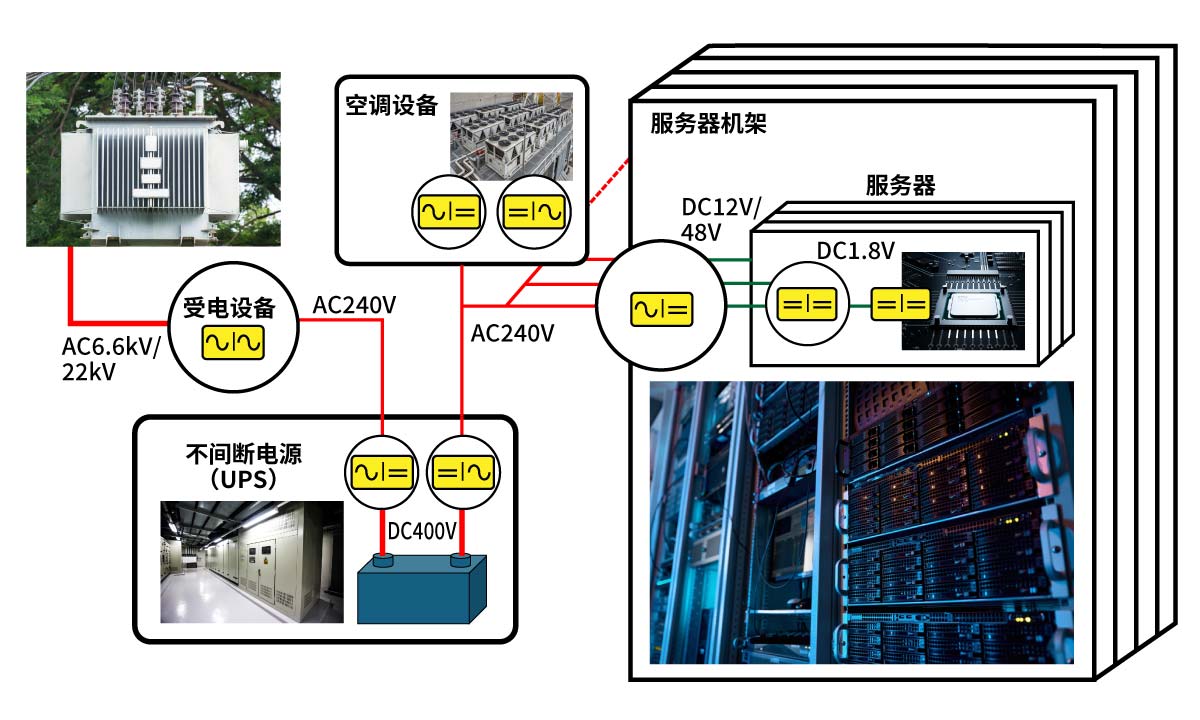

一般的数据中心从电力系统引入6600V的交流电,而大规模据点则引入被称为特别高压受电的22000V的交流电。对电力进行反复转换后,用于运行服务器、空调等内部设置的设备(图4)。例如,对于前沿芯片而言,服务器CPU中的晶体管通过低于1V的低电压直流电力运行。在将引入的高压电力转换为驱动晶体管的电力之前,场地内电网、不间断电源(UPS)内部、服务器机架入口、服务器电路板和半导体芯片内部都要进行多次电力转换。在每次转换过程中都会损失部分电能,这种损失会造成浪费。

近年来,用碳化硅(SiC)和氮化镓(GaN)等电力效率更高的新型半导体材料制成的芯片取代传统的硅基芯片作为构成这些电源系统上的电力转换电路的功率半导体的动向越发活跃。通过利用这些基于新材料的功率半导体,可以提高转换电路内部的开关频率,从而可以使用相应更小的电容器和变压器等。要实现这种效率高、小型化的电源,就需要更小且能承受更大电流的无源元件。

在设备层面的低耗电量化

到目前为止,降低数据中心耗电量的措施主要以在冷却系统和电源系统上采取对策为中心。另一方面,作为热源的处理器(CPU和GPU等)和内存等方面的对策则处于被视为不能进入的领域、未曾着手的状态。这是因为提高性能是特别优先的项目。然而,预计今后AI相关处理任务的负荷将急速增加,现在对这些半导体也需要采取降低耗电量的根本性对策。

预计未来的数据中心对AI相关处理中的演算处理需求将急速增长。在这样的处理当中,处理器和内存之间的数据传输频度和数据量比其他任务高很多。为了降低AI相关处理的耗电量,人们正在推进引入通过三维堆叠来缩短处理器和内存之间布线长度的技术。近年来,一种被称为“chiplet”的大规模前沿半导体贴装技术备受关注,这种技术将大规模芯片有目的地分解成多个较小的芯片(chiplet),并集成在一个封装内。有望在力争降低AI相关处理的耗电量的三维堆叠中也适用面向该chiplet的技术。

而且,人们还在尝试利用光通信技术连接处理器和内存,预计在不久的将来就能投入实际应用。在目前的服务器板上,数据传输的媒介是电信号,因此布线电阻和充放电会导致产生损耗,从而产生耗电量。如果将其改为光通信,就有可能加快数据传输的速度,同时尽可能地减少传输过程中的耗电量。但是,由于需要将电信号转换成光信号的新元件,因此需要新技术来提高这部分的转换效率和进行转换元件贴装等。目前,在该领域的的技术开发正在不断推进。

如果不降低耗电量并采取散热对策,数据中心的处理能力就无法提高。今后,预计在这一领域进行技术开发和引入创新性技术将接踵而至。